一个group id 会分配到 __consumer_offsets 的某一个partition上,那么如果这个group id提交的ack的标识qps 很高,则可能会导致kafka内部消费这个partition积压。

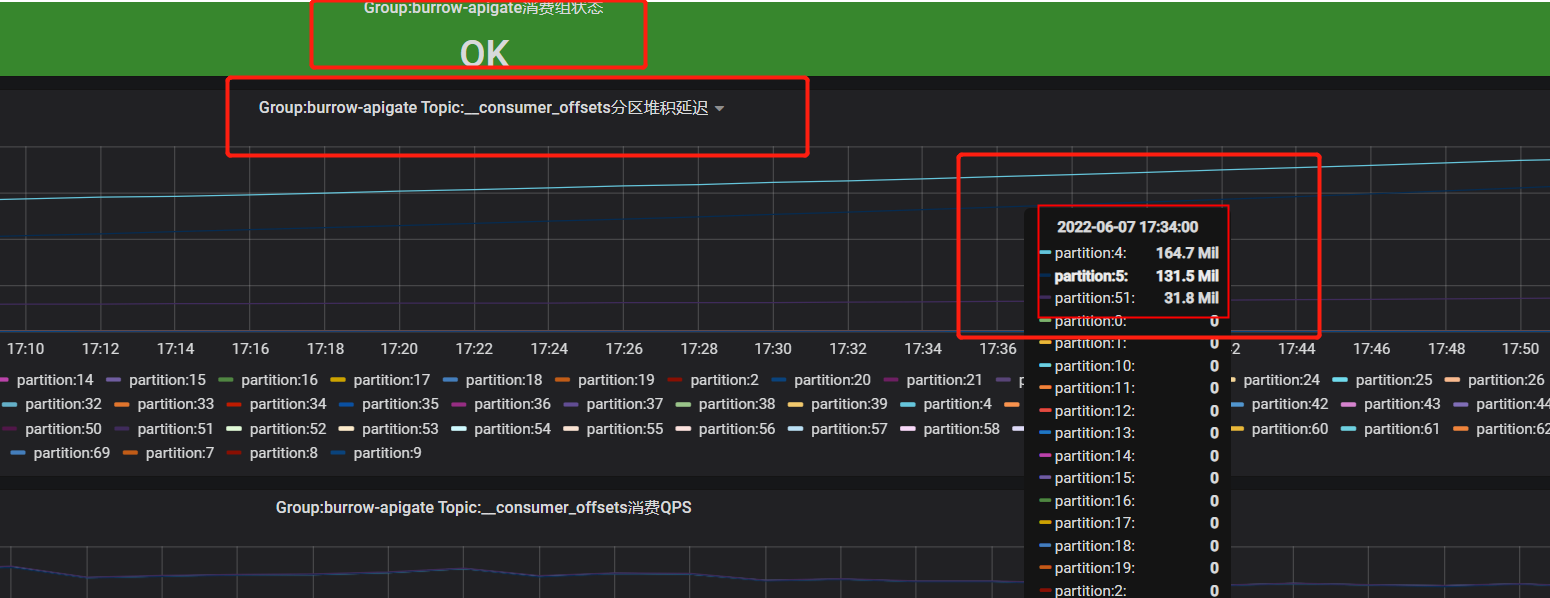

从监控中可知,该 __consumer_offsets topic对应的某几个Partition生产消息的QPS较高。

查看对应的消费组消费堆积延迟的监控,可以看到某几个Partition消费是延迟的。

那么此时,按照groupId 会被hash到某一个Partition的这种方式,此时我们就需要知道那些消费组GroupId被hash到了这个Partition,然后持续在提交ack的位移数据,导致的partition积压。我们只需要登录kafka服务器,查看该partition下具体的文件内容即可,可以参考之前博客园发过的这个内容:https://www.cnblogs.com/zh94/p/14086349.html

该group下发送的msg本身就是 groupid+topic+partition +offset 的集合,只要对数据进行分析即可。

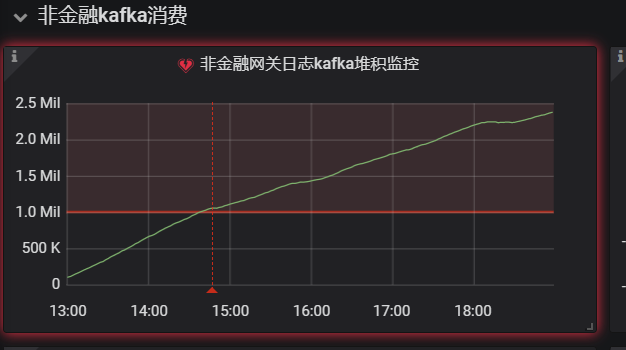

那么对于consumer topic对应的group消费积压的情况,则可能导致监控数据的不准确。

比如,监控该正常Topic 的groupid消费的实时积压数据,但是由于该Topic的groupid和其它的Topic的groupId都hash到了一个Partition上,这将会导致该正常的Topic的groupid的消费监控的指标数据拉取时收到影响。

可参考资料:

https://cloud.tencent.com/developer/article/1846774

https://blog.csdn.net/weixin_43704599/article/details/107742641

https://blog.csdn.net/weixin_43767015/article/details/122005747